杨乃1,连晓娜1,袁玥2,黄明仁2,李乔石2,林鑫11. 中国地质大学(武汉)地理与信息工程学院,武汉 430078;2. 中国地质大学(武汉)艺术与传媒学院,武汉 430074摘 要:随着时空信息的爆炸式增长,如何在保留地图可视化传统优势的基础上实现时空信息可听化是一个值得研究的方向。因此,首先以2022年纽约市 PM2.5 污染情况为例,采用通用克里金法对 PM2.5污染浓度数据进行插值,得到纽约市 2022年365幅PM2.5浓度专题地图;其次,提取每张专题地图的色相、饱和度、明度平均值,并将它们与PM2.5浓度数据的标准差分别映射为音色、音高、音强、音长四个维度的耳标参数,使用Sibelius编排创建乐曲,实现纽约市2022年PM2.5数据的可听化;最后,对可听化的污染意象信息传递效果进行评估。结果显示:①污染浓度最严重比最不严重和不严重信息的传递效果好;②污染浓度变化最大和变化较大比变化最小信息的传递效果好;③污染浓度地域差异变化最大比变化最小信息的传递效果好;④音强和音高传递污染浓度信息的效果最佳,被试者的认可度也最高,而音长传递污染地域差异的效果最差;⑤被试者对于使用以上可听化形式来传递污染信息的态度持中立到同意的态度,但在理解上存在一定难度。实验拓展了时空信息可听化的研究内容,丰富了对于地图可听化技术的探索。关键词:可听化;时空信息;PM2.5;耳标参数;HSV颜色空间;分层设色;映射模型引用格式:杨乃, 连晓娜, 袁玥, 黄明仁, 李乔石, 林鑫. 2024. 基于颜色–耳标参数映射的时空信息可听化方法. 时空信息学报, 31(4): 469-481Yang N, Lian X N, Yuan Y, Huang M R, Li Q S, Lin X. 2024. A method for sonification of spatiotemporal information based on color-earcon parameter mapping. Journal of Spatio-temporal Information, 31(4): 469-481, doi: 10.20117/j.jsti.2024040011 引言

可视化是时空信息传输与表达的主要手段,将海量数据呈现于方寸屏幕间容易造成视觉显示繁杂、地图视觉载负量剧增等问题(Brewster,1997)。对于视障人群或者身处无法满足视觉要求的复杂工作环境内的人而言,可视化技术对他们日常生活、工作与学习益处不大(Mynatt,1997;Walker等,2007)。可听化是将数据转换为声音信号的过程。人类的多通道感知避免了信息单一通道的过载和信息获取的简单化(Flowers等,2005)。可听化独立表达或辅助视觉表达,对地理信息传递、表达和认知具有重要意义和实用价值,对解决视觉感知过载、多界面、大屏幕显示、信息爆炸和批判性表达等问题尤为重要(Flavell,1997;Smilek等,2001;余英林等,2001;Fleming,2014)。

目前,时空信息可听化方面的研究主要包括听觉辅助信息表达与数据可听化两方面。听觉辅助信息表达常用于配合加强表现某种属性特征。如Gaver(1986)提出了听觉图标的概念,仿效了人们在日常生活中通过听觉获取信息的方式,在系统界面对交互的声音进行夸张模拟,来向用户传达计算机系统中的维度数据和概念对象;李伟和陈毓芬(2009)提出了可听化表达体系包括信息提取、信息处理、声音映射、声音合成和声音播放共五部分,并在降雨预报专题图中通过可听化实现了降雨量信息的辅助表达;谢静等(2023)将地形的空间特征转化为音乐的形式,并以地形音乐的乐理指标为研究对象,深入探讨了陕北黄土高原地形的空间分异特征和内在机理。数据的可听化广泛应用于环境、城市规划、交通管理等多个领域。如谢文俊等(2018)通过构建基音音名、泛音频率与PM2.5平均值之间、音量大小与不同空间污染等级涵盖的监测站点数之间的映射模型,实现了PM2.5数据的可听化;Stienen等(2019)提出了在模拟城市交通过程中实现声景化的策略,实现了在城市交通仿真中实时生成逼真的声音环境;Misdariis等(2019)设计了一个由2D到多声道算法的虚拟音频环境以呈现不同车辆来源的城市声景,并测量每个合成声音场景引起的感知烦恼程度。另外,吴明光等(2024)结合声音景观理论和城市印象理论提出了一种从带位置标签的声音数据中解析声音地图元素并进行声音制图的方法,采用了联觉的思路来设计图形符号。

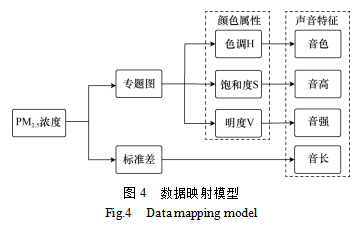

总体上,时空信息可听化相关研究已经受到重视,地图作为时空信息表达的一种主要手段,尚未有研究以地图为桥梁,充分发挥地图的优势,来实现时空信息–地图–可听化。因此,本文将时空信息以颜色为主可视化成地图,通过建立颜色的三个基本属性(色相、明度、饱和度)、数据的标准差与声音的物理特征(音色、音高、音强、音长)之间的数学关系,实现可听化效果;并对这种可听化模型的可用性与易用性进行评估。

2 数据与方法

采用纽约市2022年18个监测站点全年的PM2.5污染数据,从空气质量数据网站和谷歌地图API获取污染数据与监测点位置信息。对于个别站点缺失的PM2.5数据,根据该站点缺失日期前后的PM2.5数据,采用线性插值的方式进行补全。纽约市行政边界数据来源于ArcGIS网站,结合监测站点信息可视化展示,如图1所示。

首先将纽约市PM2.5数据以颜色为主要视觉变量可视化成地图,其次提取地图的色相(hue,H)、饱和度(saturation,S)、明度(value,V)特征数据,最后通过映射模型将地图转换为声音,从而将纽约市不同时期的PM2.5污染状况及变化趋势可听化。主要技术流程如图2所示。

2.1 PM2.5浓度的可视化表达

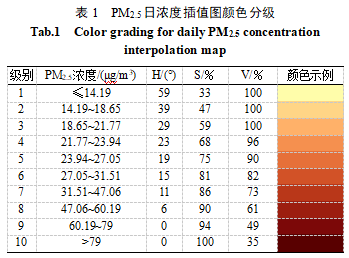

本文采用常用于点数据插值的通用克里金法,将离散的监测点数据转换为连续曲面(陈子轩和何丹,2022;张菲凡等,2022);使用ArcGIS生成以颜色为主要视觉变量的PM2.5浓度地图,根据一年中PM2.5浓度的范围采用自然断点法分级。为体现数据差异性和在其他领域应用的泛化性,实验未参考《环境空气质量指数(AQI)技术规定(试行)》(HJ 633—2012)对空气质量指数级别划分的规定,而是将颜色重新划分为10个等级,然后使用分层设色法将不同等级的浓度值用不同的颜色表示,见表1。

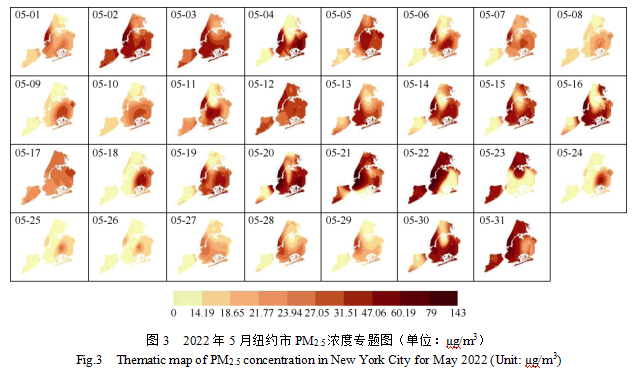

使用以上配色标准,为2022年的每一天制作出具有相同图例标准的PM2.5浓度专题地图,其中, 5月PM2.5浓度专题图如图3所示。可以看出,5月纽约市PM2.5污染中心总体上呈现由中部地区向东部地区,再向西部地区变化的趋势。

以颜色为主要视觉变量的地图表达,其信息传递主要通过颜色三个基本属性(色相、饱和度和明度)的差异化设置来实现,为了实现信息的可听化,需要提取这三个属性值。因此,分别提取纽约市2022年每一天的PM2.5浓度专题地图H、S、V特征平均值,进而实现地图的颜色分割。同时将时间维度叠加,为后续的时空信息可听化映射模型提供了数据支持。实验选用OpenCV来实现地图的HSV特征提取。时空信息的可听化过程中最主要的部分是建立有效的声音映射模型,声音映射通常采取某些技术或方法将某种信息或数据映射到声音维度,以便用户通过听觉方式来感知和理解这些信息(郝宇,2010)。耳标是一种以声音的形式传递信息的符号系统,通常是一段简短的音频片段,它们可以用于提供反馈、警告、通知和其他信息,以增强用户界面的交互性和可用性(李黎萍等,2011)。耳标参数包括音色、音高、音强及音长四部分(Blattner等,1989)。其决定了声音的质性差异,建立颜色三属性与耳标四参数之间的映射关系可以实现时空信息的可听化。因此,本文将颜色参数H、S、V与音色、音高、音强关联,为体现空间异质性,将PM2.5浓度值的标准差与音长关联。实验构建的映射模型如图4所示。

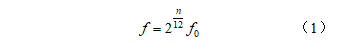

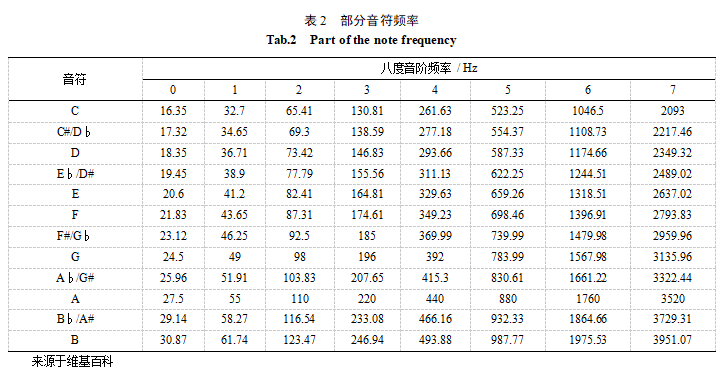

色相和音色分别反映了颜色和声音质的差异,因此可以将色相映射为音色。PM2.5浓度专题地图(图3)中采用邻近色,可选用同一种音色来表示该信息。结合数据的性质及用户的习惯和感知,同时,避免音色选择过于复杂和难以区分,降低可听化的效果,因此,选用乐器音色中的钢琴音来表示PM2.5浓度专题地图的色相。音高是人耳对于音频高低程度的感知,通常用音高名来表示,如C、D等,在音乐中,每个音符都有对应的音高。一个音符的音高与其对应的频率成正比,即频率越高,音高越高。音高与频率的关系通常用十二平均律计算得到,十二平均律是一种音乐音高的计算方式。在十二平均律中将八度音域分成12个等距的半音,每个半音之间的频率比为 21/12(徐飞,1994)。八度是相邻音组中具有相同音名的两个音之间的音程关系,其频率关系为2︰1,如A4与A3之间的频率比为2︰1。

式中,f为频率,Hz;f0为参考频率,通常为国际标准音高A4,即440Hz;为相对于基准音的半音数,如果是升高则为正数,降低则为负数。部分音符频率见表2。

由表1知,PM2.5浓度越高,颜色饱和度越高。声音频率越高,也就是越尖锐时,会让人感知到污染的严重性。因此,可以建立地图饱和度与耳标频率的映射关系,从而进一步得到与音高的联系。采用的频率范围涵盖了音高A0 ~ C7(由表2中组合得到),其频率范围为27.5 ~ 2093 Hz,根据式(2)进行映射:式中,F为耳标频率,Hz;S为地图饱和度,取值[0,255];F1、F2为已知频率的上、下限。结合十二平均律,计算得到纽约市2022年每一天的PM2.5浓度专题图所对应的耳标频率F及其对应的音高,其中,2022年5月的数据见表3。

3)将地图明度映射到耳标音强

音强是人耳感知声音的强度,它是人对声音大小的一个主观感觉量,如同人对颜色明暗程度的主观感受一样。因此,在PM2.5浓度专题地图中,将地图明度映射到耳标音强,明度越小,音强越强。本文将365 d的PM2.5浓度专题地图的明度,按照从低到高等差分为八个等级,其中,D1~D7为分级指标。明度小于D1为第一级别,音强为极强,简谱记为fff;明度介于D1~D2为第二级别,音强为很强,简谱记为ff;明度介于D2~D3为第三级别,音强为强,简谱记为f;明度介于D3~D4为第四级别,音强为中强,简谱记为mf;明度介于D4~D5为第五级别,音强为中弱,简谱记为mp;明度介于D5~D6为第六级别,音强为弱,简谱记为p;明度介于D6~D7为第七级别,音强为很弱,简谱记为pp;明度大于D7为第八级别,音强为极弱,简谱记为ppp。等级计算原理如

式中,Dn为分级指标;Vmax、Vmin为OpenCV中地图明度的最大值与最小值。经过计算,得到纽约市2022年每一天的PM2.5浓度专题地图所对应的音强属性,其中,2022年5月的数据见表4。

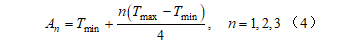

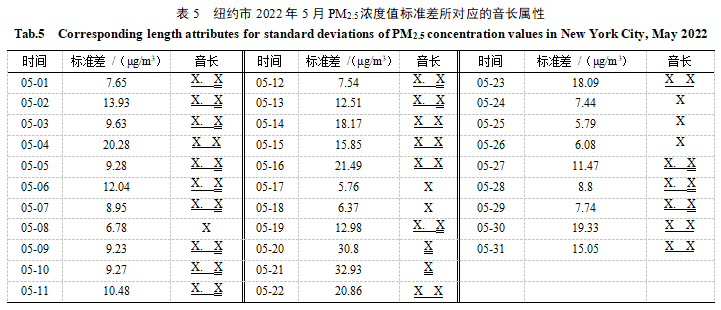

标准差常用来衡量数据的离散程度,更大的标准差意味着数据点之间的差异更大,较小的标准差表示数据点间的差异更接近平均值。音长是音符持续的时间,也可以称为音符的时值。当数据的标准差较小时,意味着数据值比较集中,不太分散,在音乐中,可以将这种情况映射为较长的音符,代表PM2.5浓度变化相对平稳,没有明显的起伏;当数据的标准差较大时,说明数据值分散较广,在音乐中,可以将这种情况映射为较短的音符,表示PM2.5浓度变化波动较大。将同一天纽约市不同区域的PM2.5浓度值的标准差,按照从低到高等差分为四个等级,其中,A1~A3为分级指标。标准差小于A1为第一级别;标准差介于A1~A2为第二级别;标准差介于A2~A3为第三级别;标准差大于A3为第四级别。四个级别分别一一对应以下四种常见的音长属性:四分音符,简谱记为X;八分音符,简谱记为X X;附点八分音符,简谱记为X. X;十六分音符,简谱记为X。其计算原理如

式中,An为分级指标;Tmax、Tmin为PM2.5浓度值标准差的最大值与最小值,μg/m3。经过计算,得到纽约市2022年每一天的PM2.5浓度值标准差所对应的音长属性,其中,2022年5月的数据见表5。

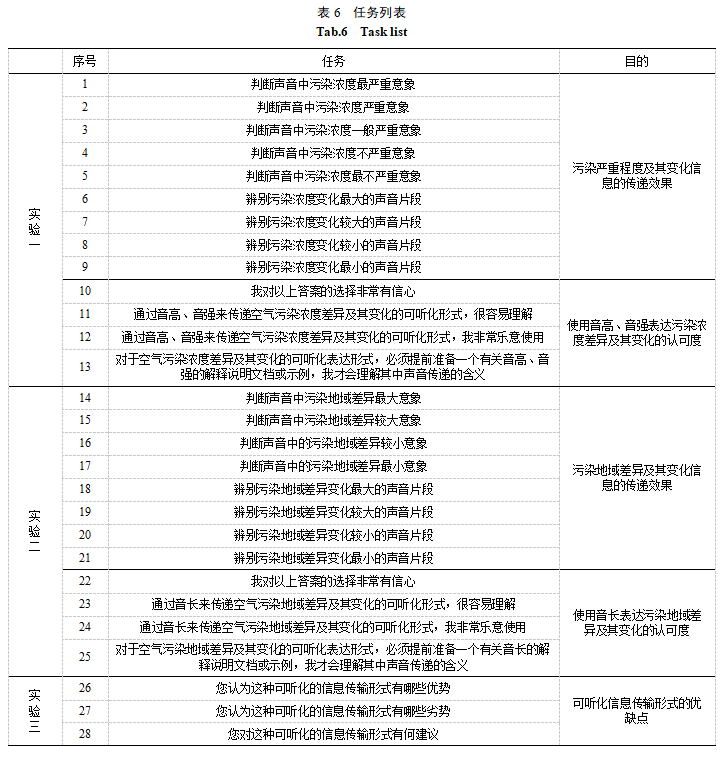

实验使用Sibelius创建乐曲,编排音乐时,一天为一个独立的音符,音符由音长、音高与音强三个属性组成。按照上文所述映射模型,计算每天的PM2.5浓度数据对应的音长、音高与音强,并为每一天的音符设置相应属性,再将音符按时间顺序依次输入。认知心理学认为,表象是记忆对经历过的事物产生的映象,是客观事物形象的遗留(彼得罗夫斯基,1981)。意象是在大量表象基础上的信息加工,是更高阶的思维活动(夏之放,1990)。为了对上文所述时空信息可听化后的效果进行评估,实验以问卷调查的形式开展了用户研究,通过意象辨识率来量化评估。意象辨识率是指参与者听取一段音乐并尝试识别其中包含的时空信息准确度,其原理为,正确辨别该意象的人数除以实验总人数,取值[0,1]。为了有效地对比分析被试者对于不同污染意象的识别效果,在实验开始前告知被试者污染意象与声音音高、音强、音长的对应关系。实验分为三部分进行。第一部分评估污染严重程度及其变化信息的传递有效性,以及被试者对使用音高和音强表达污染浓度的认可度,参与者需要完成表6中任务1~13。第二部分评估污染浓度地域差异及其变化信息传递的有效性,以及被试者对使用音长表达污染浓度地域差异的认可度,参与者需要完成表6中任务14~25。其中,任务1~5选择了五个具有明显差异性的污染浓度所对应的声音片段,任务6~9选择了四个具有明显差异性的污染浓度变化所对应的声音片段;任务14~17和任务18~21分别选择了四个具有明显地域差异和地域差异变化的污染浓度所对应的声音片段。第三部分调查这种可听化形式的优缺点及建议,被试者需要完成表6中的任务26~28。问卷任务1~25为单选题,任务26~28为填空题。任务1~5与任务14~17为在完整听完一段声音后,再结合听取指定播放位置2~4 s声音片段后,判断该片段声音污染浓度等级和浓度地域差异等级。任务6~9与任务18~21为每个任务听取一段17~19 s不同的声音后辨别污染浓度变化等级和浓度地域差异变化等级。以上所有声音均可反复收听。任务10~13与任务22~25采用五分李克特量表调查被试者对于使用音高、音强和音长表达污染的认可度。任务26~28为填写这种可听化形式的优缺点及建议。以上问卷于2024年1月15~20日完成,共有44名参与者。参与者年龄集中在22~25岁,平均年龄为23岁,其中男性20人、女性24人,所有参与者均无听力障碍。平均作答时长为256 s,删除作答时长远低于其平均时长的若干无效问卷,收获34份有效问卷。

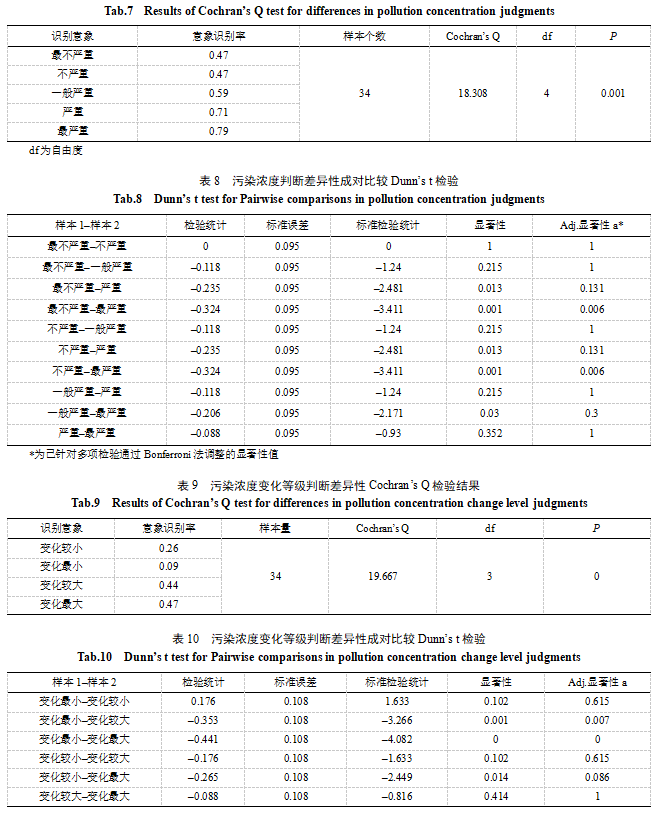

Cochran’s Q检验的结果(表7)显示,污染浓度意象差异显著性P值为0.001,说明数据总体存在显著差异性。经Bonferroni法校正的Dunn’s t检验结果(表8)显示,被试者辨识最严重与最不严重、不严重的意象存在差异性,且最严重的识别率大于最不严重、不严重的识别率,说明被试者对于音高、音强表达污染浓度时,对污染最严重的识别要好于污染最不严重和不严重的识别。Cochran’s Q检验的结果(表9)显示,污染浓度变化意象差异显著性P值为0<1%,说明数据总体存在显著差异性。经Bonferroni法校正的Dunn’s t检验结果(表10)显示,被试者辨识变化最小与变化较大、变化最大的意象存在差异性,且变化较大与变化最大的识别率均大于变化最小的识别率,说明被试者对于音高、音强表达污染浓度变化时,对污染浓度变化较大与最大的识别要好于污染浓度变化最小的识别。

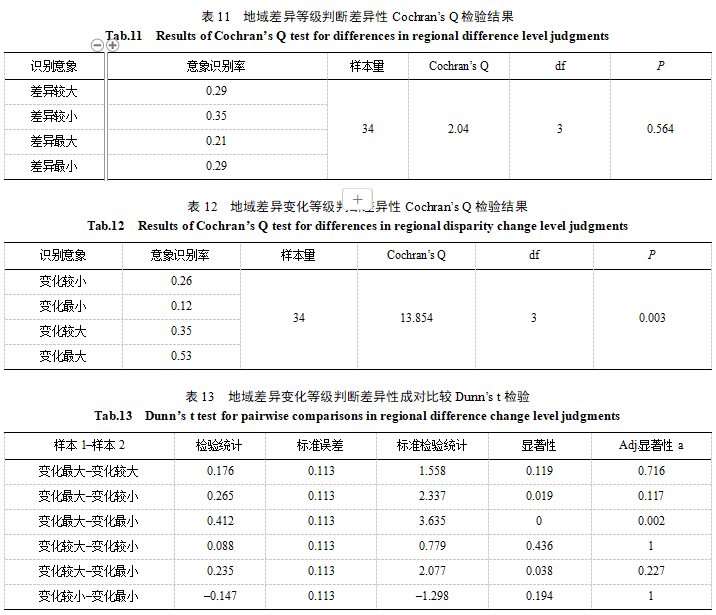

Cochran’s Q检验的结果(表11)显示,辨别污染地域差异显著性P值为0.564>5%,说明被试者对于使用音长表达污染地域差异的辨别总体上不存在显著差异性。Cochran’s Q检验的结果(表12)显示,辨别污染地域差异变化显著性P值为0.003<1%,说明数据总体存在显著差异性。经Bonferroni法校正的Dunn’s t检验结果(表13)显示,被试者辨识污染地域差异变化最大与变化最小存在显著差异性。变化最大的识别率大于变化最小的识别率,说明被试者对音长表达污染地域差异变化时,对变化最大的辨别要显著好于变化最小的辨别。

对污染浓度、污染浓度变化、污染地域差异和污染地域差异变化的总体意向识别率进行了差异性分析。由表14可知,样本N5000,采用S-W检验,数据呈现显著性,不满足正态分布,可以进行Friedman检验。通过Friedman检验分析结果(表15)可知,显著性P值为0.002,说明被试者通过以上可听化形式对污染浓度、污染浓度变化、污染地域差异、污染地域差异变化的辨识结果存在显著差异;其差异幅度Cohen’s f值为0.463,差异程度大。事后多重比较采用Nemenyi两两比较差异性,由表16可知,污染浓度与污染浓度变化、污染地域差异、污染地域差异变化之间的辨识结果均存在显著性差异,且配对差值均大于0,说明污染严重程度的识别率大于污染浓度变化、污染地域差异、污染地域差异变化的识别率,结合上文所述各项意向识别率可知,使用音强和音高传递污染浓度的信息效果最佳。

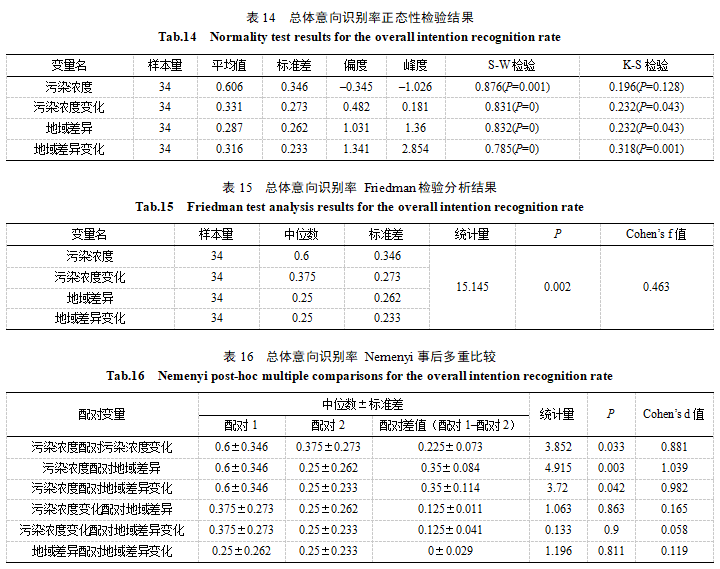

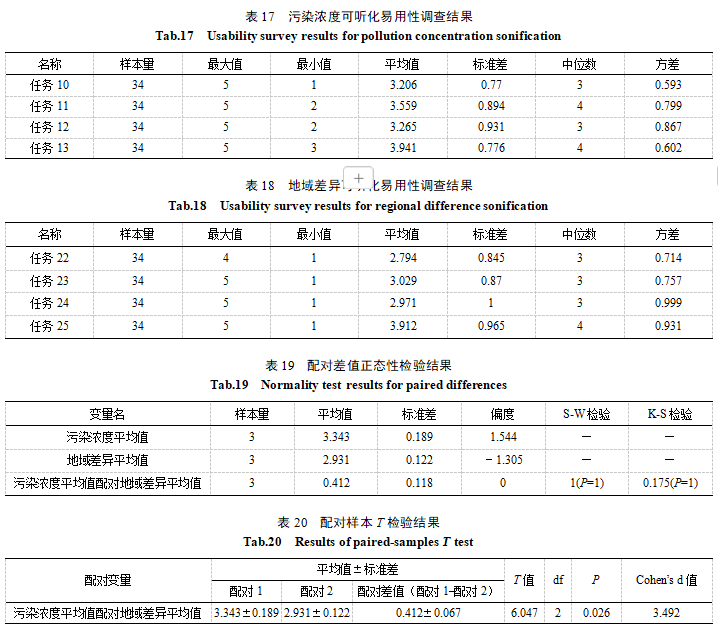

通常采用五分李克特量表调查用户对于使用音高、音强和音长表达污染的认可度(Joshi等,2015)。描述性指标分析见表17~18,这些分数的中位数为3或4,表明大多数被试者对于使用音高、音强和音长来表达污染情况持中立到同意的态度。但被试者对于任务13、25的测试平均值均达到了3.9,说明仍然需要说明文档或示例来帮助被试者理解可听化的含义。对任务10~12和任务22~24进行差异性分析。由表19可知,样本N5000,采用S-W检验,显著性P值为1,水平上不呈现显著性,因此数据满足正态分布,可以进行配对样本T检验。配对样本T检验的结果(表20)显示,基于变量污染浓度平均值配对地域差异平均值,显著性P值为0.026,水平上呈现显著性,因此说明污染浓度平均值与对地域差异平均值之间存在显著性差异。其差异幅度Cohen’s d值为3.492,差异幅度非常大;且配对差值大于0,污染浓度平均值大于地域差异平均值,说明被试者对使用音高、音强表达污染浓度信息的认可度更高。

声音具有良好的操纵性,可以方便地进行数字信号处理和组合。然而,声音也具有抽象性的特点,导致需要经过一定时间的学习才能识别和记忆耳标所要表达的信息。从被试者对可听化信息传输形式的优缺点及建议反馈(任务26~28)可知,这种可听化形式,与传统地图可视化形式相比具有独特之处,但对传递的信息理解存在一定挑战。根据表14,从污染浓度的意象识别率平均值可知,被试者对音高、音强传递信息的理解较好;从地域差异及地域差异变化的意象识别率平均值可知,被试者对音长传递信息的理解较差。另外,被试者也提出了增强音乐层次变化、融合图像表达及借鉴各类音乐类型创作等建议。4 结 论

以纽约市2022年每一天的PM2.5浓度为例,建立了一种颜色–耳标可听化映射模型,并尝试利用音色、音高、音强、音长传递污染浓度、污染浓度变化、污染地域差异和污染地域差异变化信息的效果进行评估。结果表明:①对传递污染浓度信息,最严重比最不严重和不严重较好;②对传递污染浓度变化信息,变化最大和变化较大比变化最小好;③对传递污染浓度地域差异变化信息,变化最大比变化最小较好;④音强和音高传递污染浓度信息的效果最佳,被试者的认可度也最高。总体上,这种基于颜色–耳标映射模型实现的可听化形式存在一定认知难度,在信息传递方面并未达到可视化的效果,尤其像音长,只反映了差异性的大小变化,并不能像地图一样可以清晰地反映差异的空间分布,毕竟,可听化并不是一种形象化的信息传输手段,空间分异的直观表达是可听化在信息传输方面存在的先天不足。尽管被试者对本文所提出的可听化形式用于污染时空信息的传递表现出较好的认可度,污染浓度及其变化的识别率相对较高,但污染地域差异比和污染地域差异变化识别率差强人意。究其原因可能是地图的插值、分级、配色及可听化过程中缺乏泛音等,在未来的时空信息可听化实现中,应加强对地图分层设色的深入研究,采用更具差异性的音乐元素来区分不同程度的污染情况和空间分异特征。此外,实验使用的音色为钢琴音,使用不同音色的可听化效果的对比还有待进一步研究;被试者的年龄、性别、音乐素养等也是将来对可听化效果进行科学评估需要考虑的因素。

彼得罗夫斯基. 1981. 普通心理学. 朱智贤, 译. 北京: 人民教育出版社[A. B. Петровский. 1981. General Psychology. Zhu Z X, trans. Beijing: People’s Education Press (in Chinese)]陈子轩, 何丹. 2022. 北京市住宅价格空间分异特征及影响因素分析. 地理信息世界, 29(2): 74-78, 82[Chen Z X, He D. 2022. Analysis on spatial differentiation characteristics and influencing factors of housing price in Beijing. Geomatics World, 29(2): 74-78, 82 (in Chinese)]郝宇. 2010. 基于数字图像处理的声音导行系统的设计与实现. 硕士学位论文. 沈阳: 东北大学. [Hao Y. 2010. Design and accomplishments of sound navigation system based on digital image processing. Shenyang: Northeastern University (in Chinese)]李黎萍, 张世琴, 蒋明. 2011. 听标耳标学习: 噪音干扰和环境依赖性的差异//增强心理学服务社会的意识和功能——中国心理学会成立90周年纪念大会暨第十四届全国心理学学术会议, 西安. 446-447[Li L P, Zhang S Q, Jiang M. 2011. Learning auditory icon and earcon: Noise interference and context dependency differ// Enhancing the Awareness and Function of Psychological Services in Society—Proceedings of the 90th Anniversary of the Chinese Psychological Society and the 14th National Conference, Xi’an,China. 446-447(in Chinese)]李伟, 陈毓芬. 2009. 地理信息的可听化表达研究. 测绘科学技术学报, 26(5): 383-386, 390[Li W, Chen Y F. 2009. Research on sonification expression of geographical information. Journal of Geomatics Science and Technology, 26(5): 383-386, 390 (in Chinese)]吴明光, 孙彦杰, 路威, 王静文. 2024.声音地图: 元素解析与符号化方法研究. 地球信息科学学报, 26(1): 56-71 [Wu M G, Sun Y J, Lu W, Wang J W. 2024.Of sound maps: Methods of element analysis and symbolization. Journal of Geo-Information Science, 26(1): 56-71 (in Chinese)]夏之放. 1990. 论审美意象. 文艺研究, (1): 27-36[Xia Z F. 1990. On aesthetic images. Literature & Art Studies, (1): 27-36 (in Chinese)]谢静, 陈楠, 林偲蔚. 2023. 基于地形音乐的地形定量分析与空间分异研究——以陕北黄土高原为例. 地球信息科学学报, 25(5): 924-934[Xie J, Chen N, Lin S W. 2023. Quantitative analysis and spatial differentiation of terrain based on terrain music: Example of Loess Plateau in northern Shaanxi. Journal of Geo-Information Science, 25(5): 924-934 (in Chinese)]谢文俊, 祝茂良, 杨鸿海, 杨乃, 吕建军. 2018. PM2.5地图可视化中的听觉感知应用. 测绘通报, (11): 111-114, 125[Xie W J, Zhu M L, Yang H H, Yang N, Lyu J J. 2018. Auditory perception application in PM2.5 map visualization. Bulletin of Surveying and Mapping, (11): 111-114, 125 (in Chinese)]徐飞. 1994. 朱载堉十二平均律算法考. 音乐探索(四川音乐学院学报), (4): 54-59[Xu F. 1994. An examination of Zhu Zaiyu’s algorithm for the twelve-tone equal temperament. Explorations In Music(Journal of Sichuan Conservatory of Music), (4): 54-59 (in Chinese)]余英林, 田菁, 蔡志峰. 2001. 图像视觉感知信息的初步研究. 电子学报, 29(10): 1373-1375[Yu Y L, Tian J, Cai Z F. 2001. Research of perceptive information of image. Acta Electronica Sinica, 29(10): 1373-1375 (in Chinese)]张菲凡, 韩念龙, 纪旭, 胡珂. 2022.基于GWR模型的房价空间影响因素研究——以海口市海甸岛为例. 地理信息世界, 29(1): 52-57[Zhang F F, Han N L, Ji X, Hu K. 2022.Research on spatial influencing factors of house price based on GWR model: A case study of Haidian island in Haikou City. Geomatics World, 29(1): 52-57 (in Chinese)]Blattner M, Sumikawa D, Greenberg R. 1989. Earcons and icons: Their structure and common design principles. Human-Computer Interaction, 4(1): 11-44Brewster S A. 1997. Using non-speech sound to overcome information overload. Displays, 17(3/4): 179-18Flavell J H. 1977. The development of knowledge about visual perception. Nebraska Symposium on Motivation, 25, 43-76Fleming R W. 2014. Visual perception of materials and their properties. Vision Research, 94: 62-75Flowers J H, Buhman D C, Turnage K D. 2005. Data sonification from the desktop. ACM Transactions on Applied Perception, 2(4): 467-472Gaver W. 1986. Auditory icons: Using sound in computer interfaces. Human-Computer Interaction, 2(2): 167-177Joshi A, Kale S, Chandel S, Pal D. 2015. Likert scale: Explored and explained. British Journal of Applied Science & Technology, 7(4): 396-403Misdariis N, Dianoux C, Marignier L, Leiba R. 2019. Community noise quality assessment (annoyance) by means of a virtual audio environment // INTER - NOISE and NOISE - CON Congress and Conference Proceedings, 259(9): 460-471Mynatt E. 1997. Transforming graphical interfaces into auditory interfaces for blind users. Human-Computer Interaction, 12(1): 7-45Smilek D, Dixon M J, Cudahy C, Merikle P M. 2001. Synaesthetic photisms influence visual perception. Journal of Cognitive Neuroscience, 13(7): 930-936Stienen J, Aspoeck L, Vorlaender M. 2019. Strategies for the auralization of simulated urban traffic // INTER - NOISE and NOISE - CON Congress and Conference Proceedings, 259(9): 10Walker B N, Kim J, Pendse A. 2007. Musical soundscapes for an accessible aquarium: Bringing dynamic exhibits to the visually impaired // International Computer Music Conference, ICMC 2007, 268-275↓↓ 了解更多产业要闻 ↓↓

请将我设为星标★